sort

sort

Die Grundlagen für sauberes SEO ändern sich auch im 2018 nicht. Ein guter Zeitpunkt also sich die notwendigen und fundamentalen Themen zur Suchmaschinenoptimierung in Erinnerung zu rufen. Trends und Innovationen klammern wir dabei bewusst aus.

Vorab gilt es zu prüfen, ob eine Webseite (bzw. Domain) überhaupt bei Google gefunden wird. Dazu kann folgendermassen gesucht werden: "site:arteria.ch". Diese Suchanfrage listet alle Seiten bzw. Unterseiten der gesuchten Domain auf, die Google bekannt sind.

Wird eine Webseite nicht gefunden, kann das verschiedene Gründe haben:

Grundsätzlich findet und indexiert Google eine Webseite früher oder später. Eine «Anmeldung» der Webseite bei Google ist nicht nötig. Damit Google auch alle Unterseiten sofort erkennen und durchsuchen kann, empfiehlt es sich eine Sitemap zu hinterlegen. Sie ist eine technische Auflistung der Struktur einer Webseite im XML-Format.

Um eine Suchmaschine davon abzuhalten gewisse Inhalte zu indexieren, muss eine robots.txt-Datei hinterlegt werden. Sie instruiert den «Google-Crawler» welche Seiten bzw. Strukturen ignoriert werden sollen.

Empfehlenswert ist z.B. der Ausschluss von Such-Seiten innerhalb der eigenen Webseite. Diese können sehr umfangreich sein, was dazu führt, dass Google nicht genügend Zeit zur Verfügung steht die restlichen (wichtigen!) Seiten zu indexieren. Hinzu kommt, dass ein Besucher in den Suchresultaten von Google nicht viel mit einem solchen Link anfangen kann.

Vorsicht: eine robots.txt Datei ist lediglich eine Instruktion an die Suchmaschine, aber keine zwingende Anweisung. So kann es passieren, dass Seiten trotzdem ungewünscht im Index landen. Sensitive Inhalte sollten also strikter geschützt werden. Hierfür eignet sich z.B. eine sogenannte «Closed User Group» die in jedem modernen CMS eingerichtet werden kann. Diese Inhalte sind dann nur noch via Benutzername / Kennwort zugänglich. Auch sollte man sich Gedanken darüber machen, welche Inhalte überhaupt auf die Webseite gehören und welche nur «offline» verfügbar sein sollen.

Der Google-Crawler soll eine Webseite so sehen wie jeder normale Besucher auch. Dadurch wird gewährleistet, dass alle Inhalte korrekt eingestuft werden können. Der Zugang zu Bildern sowie JavaScript- und CSS-Dateien darf daher nicht eingeschränkt sein.

Es sollte also die robots.txt geprüft werden, ob eine derartige Anweisung besteht und wenn ja, weshalb.

Im Internet ist jede URL eindeutig und zeigt auf eine spezifische Seite (mit möglichst einzigartigem Inhalt). Diese Web-Adressen werden in den Google Suchresultaten ebenfalls angezeigt. Einige «Best Practices» sollten berücksichtigt werden:

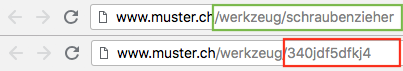

Das folgende Bild demonstriert den Vergleich zwischen einer optimalen und suboptimalen URL-Struktur für Suchmaschinen. Die grün hervorgehobene URL ist für Suchmaschinen optimal. Die rot hervorgehobene URL ist kryptisch aufgebaut und daher für Suchmaschinen ungeeignet:

Die Startseite einer Webseite ist für gewöhnlich die am meisten besuchte. Es stellt sich die Frage wieviele Inhalte insgesamt dargestellt werden sollen. Gibt es genügend Seiten die einem Themengebiet angehören, so dass es Sinn macht eine Übersichtsseite einzuplanen, auf der das Thema näher beschrieben wird? (Startseite -> Themengebiet -> Spezifische Detailseite). Müssen hunderte Produkte dargestellt werden, so dass es Kategorien und Unterkategorien benötigt?

Breadcrumbs - oder auch «Brotkrümel» - sind eine Möglichkeit um dem Besucher anzuzeigen auf welcher Seite er sich befindet, und wie diese Seite in die Hierarchie eingebettet ist. Ausserdem können die Breadcrumbs als Navigation genutzt werden, indem diese Hierarchien auch aktiv verknüpft sind. Breadcrumbs sind meist zwischen dem Header und Content vorzufinden.

Generell sollte die Navigation auf einer Webseite einfach gehalten werden. Alle Seiten müssen direkt über eine Verlinkung (z.B. via Menü) aufgerufen werden können. Dass gewisse Seiten nur via einer internen «Suchfunktion» erreicht werden können, sollte vermieden werden. Die Regel, dass jede Seite mit nur drei Klicks erreichbar sein muss, kann sicher nicht verallgemeinert werden, doch ist sie ein guter Anhaltspunkt an dem man sich bei der Erstellung einer Seitenstruktur orientieren kann.

Verlinkungen sollten, wenn möglich, mittels Text realisiert werden. Suchmaschinen können Bilder nur schwer interpretieren und verstehen so den (wichtigen!) Zusammenhang zwischen Link und Inhalt nicht. Um Google die Arbeit zu erleichtern, kann zudem eine XML-Sitemap hinterlegt werden, welche alle vorhandenen Seiten aufzeigt. Dadurch ist sichergestellt, dass die Suchmaschinen keine Inhalte «verpassen».

Es liegt in der Natur des Internets, dass Seiten auch wieder verschwinden und nicht mehr aufgerufen werden können. In diesem Fall ist es wichtig, dass eine hilfreiche und sauber gestaltete «Fehler 404» Seite zur Verfügung steht. Sie hilft einerseits dem Besucher wieder auf den richtigen Pfad zu gelangen – z.B. in dem auf die Startseite verlinkt wird. Andererseits versteht Google dadurch, dass die entsprechende Seite nicht mehr existiert und der Suchindex angepasst werden muss.

Zu einer optimalen Seitenstruktur zählen, neben den bisher erwähnten Kriterien, auch der Seitentitel mit dem <title>-Tag, die Seitenbeschreibung mit dem «description»-Meta-Tag sowie auch die Überschriften und strukturierte Daten.

Inhalte sollten so optimiert sein, dass sie der goldenen Regel «Content is king» folgen. Das bedeutet, dass dem Besucher mit dem Inhalt ein Mehrwert angeboten und auf seine Bedürfnisse eingegangen werden muss.

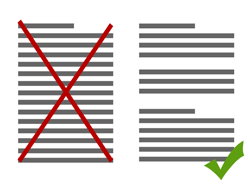

Essenziell in der Suchmaschinenoptimierung ist auch die Frage für wen die Texte eigentlich verfasst werden sollen (wer ist die Zielgruppe und wie kommuniziert sie?). Neue einzigartige Inhalte – im Fachjargon auch «unique content» genannt – sind als Erfolgsfaktor für Webseiten zu betrachten. Doppelte Inhalte, der sogenannte «Duplicate Content», wird von Suchmaschinen nicht gerne gesehen und sollte daher vermieden werden.

Gut lesbar bedeutet auch, dass grosse Textmengen in Absätzen logisch unterteilt werden und Zwischenüberschriften für thematische Abgrenzungen eingesetzt werden. Eine visuelle Trennung von Abschnitten, hilft das Gesamtbild für das Auge angenehm zu strukturieren. Es lohnt sich auch zwei oder drei Mal einen Blick auf den Inhalt zu werfen, um herauszufinden, ob sich Rechtschreibfehler eingeschlichen haben. Diese würden das Bild eines professionellen Webauftritts beeinträchtigen.

In der Suchmaschinenoptimierung gibt es eine Faustregel, was die Überschriften angeht: Jede Seite muss über (mind.) eine H1-Überschrift verfügen. Alle Überschriften, die danach folgen dürfen der Hierarchie absteigend von H2 auf H6 frei verwendet werden.

Da jedes Suchergebnis in Google eine Antwort auf eine bestimmte Suchanfrage liefert, ist es wichtig zu wissen nach welchen Kriterien Google crawlt. Die Erkenntnis über Suchanfragen der Zielgruppe sowie die Keywordrecherche (z.B. mit Hilfe des Keyword-Planers von Google) stellen dabei eine gute Basis bei der Erstellung einer optimalen Keyword-Liste dar. Nachdem die Keywords feststehen, sollten sie in URLs, Seitentiteln und -beschreibungen sowie auch im Content eingesetzt werden.

Die übermässige Verwendung von Keywords, sogenanntes «Keyword Stuffing», sollte dabei stets vermieden werden. Die Webseite darf keinesfalls «nur» für die Suchmaschine optimiert werden. Solche Seiten werden mittlerweile von Google schnell identifiziert und riskieren ein schlechteres Ranking in den Suchergebnissen.

Verlinkungen innerhalb eines Textes sollten eine passende Beschreibung erhalten. Nicht themenbezogene oder nichts sagende Beschreibungen wie z.B. «Hier klicken» sollten vermieden werden. Ideal ist es, wenn der Text dem User prägnant mitteilt, was er auf der verlinkten Seite zu erwarten hat. Weitere «Best Practices» sind die optische Hervorhebung von Links und die Verwendung eines Ankertextes für interne Links.

Bei bestimmten externen Links empfiehlt sich auch der Einsatz von «nofollow» Attributen, um der Suchmaschine zu demonstrieren, dass die Zielseite ignoriert werden kann.

Für eine barrierefreie Webseite wird gesorgt, wenn das beschreibende alt-Attribut für Bilder verwendet wird. Eine weitere Hilfe bietet ein optimierter Dateiname. So werden Bezeichnungen wie «bild1.jpg» oder auch zu lange Dateinamen durch eine sinnvolle Benennung vermieden.

Mit Hilfe einer Bilder-Sitemap werden Google weitere Informationen über die Bilder zur Verfügung gestellt und erhöht damit die Chance auf bessere Positionen in Suchergebnissen der Bildersuche. Wenn ausserdem noch darauf geachtet wird, dass die Bilddateigrösse nicht allzu gross ausfällt und der Dateityp sich für das Web eignet, sind die Bilder bestens optimiert. Bilder-Dateitypen für das Web sind u.a. JPEG, GIF, PNG, BMP und WebP.

Dem Bundesamt für Statistik zufolge surften im Jahr 2017 in der Schweiz 73% der Personen im Alter zwischen 16 und 74 Jahren mit einem mobilen Endgerät*. Das macht eine mobiloptimierte Webseite heutzutage umso wichtiger. Daher wird von Google «Responsive Webdesign» wärmstens empfohlen.

Schliesslich sollen die User auch unterwegs die Webseiteninhalte ohne langes Warten oder Mühe abrufen können. Ob die eigene Webseite mobiloptimiert ist, kann mit diesem Test auf Optimierung für Mobilgeräte von Google überprüft werden. Google unterstützt ebenfalls Webseiten mit einer dynamischen Bereitstellung. Damit ist die Identifizierung unterschiedlicher HTML- und CSS-Codes für die Desktop- und Mobilversion gemeint. Sollte die Webseite für beide Versionen unterschiedliche URLs haben (z.B. «m.muster.ch» für die mobiloptimierte Version) wird dies ebenfalls von Google registriert. Hier empfiehlt sich das Testen der URLs für Desktops und Mobilgeräte, um sicherzustellen, dass die Weiterleitung einwandfrei funktioniert. Der Nachteil dieser Strategie ist oft die Redundanz der Inhalte (Mobil vs. Desktop), die vom Anbieter mehrfach gepflegt werden müssen.

Es gibt mehrere Wege, um die eigene Webseite online erfolgreich zu promoten. Google ist daran interessiert neue Inhalte den Besuchern schnell zugänglich zu machen und indexiert täglich neue Seiten, um dies zu ermöglichen. Wer effektiver vorgehen möchte, nutzt die zur Verfügung stehenden Werbemassnahmen wie z.B. Google AdWords.

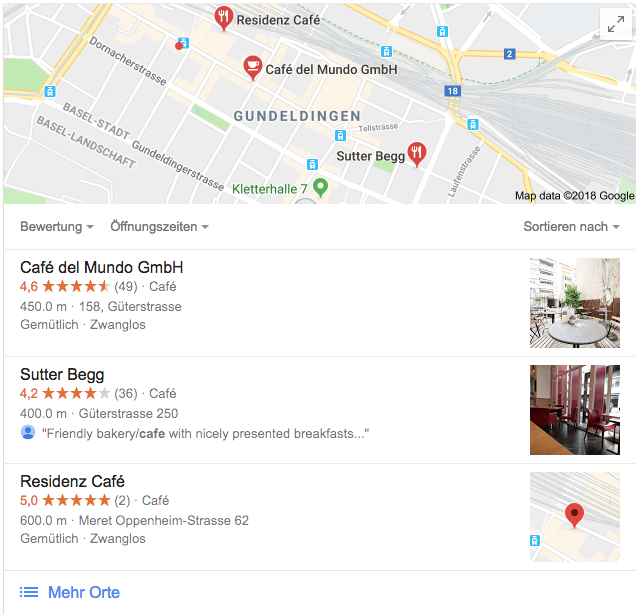

Generell und vor allem lokalen Geschäften wird der Eintrag in Google My Business empfohlen. So wird das eigene Unternehmen auch auf Google Maps gefunden und Kunden können Empfehlungen in Form von Bewertungen abgeben. In den Suchergebnissen wird wie im folgenden Bild das Unternehmen mit Informationen inkl. Bewertungen hervorgehoben.

Um eine Webseite erfolgreich zu promoten, darf das Link Building nicht vergessen werden: Verlinkungen die von anderen Webseiten zur eigenen führen sind wie Empfehlungen. Auch hier existieren Do's und Dont's: Künstlicher Linkaustausch bzw. das Kaufen von Links entspricht nicht den Richtlinien von Google und wird dementsprechend abgestraft.

Ein erfolgreiches und gutes Link Building besitzt Verlinkungen von und zu seriösen Seiten, welche im Idealfall thematisch zur eigenen Webseite passen. Social Media wie Facebook & Co. bieten ebenfalls die Möglichkeit durch «Social Signals» die Reichweite der eigenen Webseite zu erhöhen.

Für das Messen der Performance und Analysieren des Besucherverhaltens stellt Google viele Tools kostenlos zur Verfügung: Mit der «Search Console» erfährt der Webmaster, ob Google Inhalte findet und welche Leistung von den Suchergebnissen erzielt wird. Sollte Google mit dem Indexieren der Seiten Schwierigkeiten haben, wird dies in der Search Console angezeigt.

Wenn beispielsweise eine bereits indexierte URL sich geändert hat und keine Weiterleitung eingerichtet wurde, wird dies als Crawling-Fehler aufgelistet. Jeder Webseite steht täglich ein begrenztes Crawl-Budget zur Verfügung. Daher ist es wichtig für diejenigen URLs, die Crawling-Fehler verursachen, eine entsprechende Weiterleitung einzurichten.

Folgende weitere Funktionen bietet das Tool:

Ein weiteres Tool, welches das Besucherverhalten analysiert, ist «Google Analytics»: Damit erhält das Unternehmen wertvolle Informationen über das Nutzerverhalten. Mit den Daten wie z.B. Klicks, Sitzungsdauer, Absprungrate, usw. kann herausgefunden werden, welche Seiten den besten Traffic besitzen und welche Suchbegriffe die Nutzer auf die eigene Webseite führten.

Suchmaschinenoptimierung ist ein fortlaufender Prozess, der aus vielen unterschiedlichen Perspektiven betrachtet werden muss, um das ideale Ergebnis zu erzielen. Durch das Einhalten der Qualitätsrichtlinien von Google werden im Idealfall sowohl die Zufriedenheit der Nutzer als auch die Unternehmensziele erreicht.